Alibaba обновила свою генеративную модель до версии WAN 2.6. Нейросеть создаёт видеоролики в разрешении 1080p длительностью до 15 секунд и работает с текстом, изображениями и референсными видео.

Доступ к WAN 2.6 уже открыт на официальном сайте Wan и в плейграундах для разработчиков, хотя формальный релиз запланирован на завтра. Новым пользователям начисляют 150 кредитов — этого хватает на пять генераций 15-секундного видео.

Нейросеть WAN 2.6 — что нового и что умеет делать

WAN 2.6 — мультимодальная видеомодель, рассчитанная на создание коротких, но законченных сцен. Она умеет генерировать видео по текстовому описанию, по картинке и на основе референсных видео, сохраняя персонажей и визуальный стиль между кадрами.

В режиме reference-to-video можно загрузить до трёх референсных роликов. Это нужно, чтобы персонажи, объекты и окружение не менялись от сцены к сцене и выглядели стабильно на протяжении всего видео.

Модель также умеет автоматически разбивать результат на несколько планов и собирать их в готовый монтаж. Итог — не один длинный кадр, а полноценная сцена с логикой переходов.

Кроме того, WAN 2.6 меньше «плывёт» между кадрами и лучше держит персонажей, что раньше было слабым местом.

Отдельный блок — работа со звуком. В модель можно загрузить собственное аудио, при этом заявлена точная синхронизация речи и улучшенный лип-синк. Речь идёт не просто о совпадении по таймингу, а о более корректной артикуляции.

Также, теперь WAN 2.6 — это не только генерация видео. Модель поддерживает генерацию и редактирование изображений и работает с текстом внутри картинок — заголовками, надписями, интерфейсами и постерами.

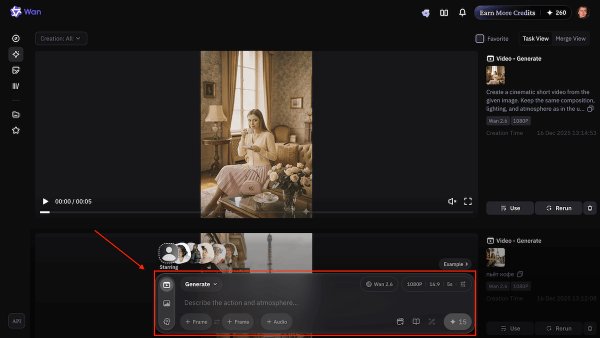

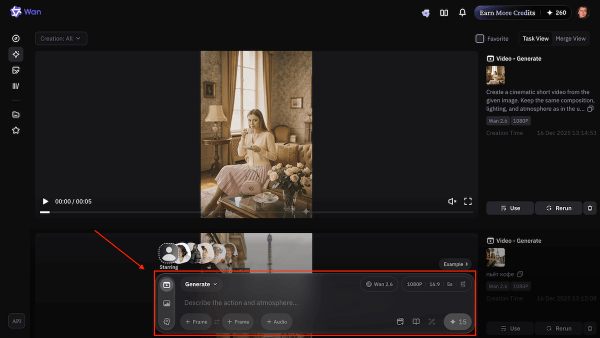

Как пользоваться WAN 2.6 и создавать видео

Протестировать WAN 2.6 можно на официальном сайте Wan и в сторонних плейграундах. После входа нужно перейти в раздел Generate, выбрать модель WAN 2.6 и режим генерации — по тексту, изображению или референсному видео.

Далее пользователь задаёт промт, выбирает формат видео, длительность, разрешение и дополнительные параметры. При необходимости можно загрузить аудио для синхронизации речи или референсные ролики, чтобы зафиксировать персонажей и стиль сцены. После запуска модель собирает готовый ролик автоматически.

Генерация одного видео длительностью 15 секунд стоит 30 кредитов. Всем пользователям сейчас выдают 150 кредитов, для генерации без ожидания. Для входа на сайт можно использовать Гугл-аккаунт.

Почему это важно? Большинство видеомоделей уже умеют делать красивые кадры, но плохо справляются со сценами, персонажами и звуком одновременно. WAN 2.6 пытается решить именно эту проблему, объединяя монтаж, референсы и аудио в одном инструменте.

Предыдущая версия модели, WAN 2.5, вышла ранее в этом году и была сосредоточена в первую очередь на базовой генерации видео. Она показывала хороший визуал, но оставалась скорее экспериментальным инструментом.

В версии WAN 2.6 Alibaba заметно расширяет функциональность. Модель теперь работает как мультимодальная система: видео, звук, изображения, монтаж и референсы. За счёт этого WAN 2.6 напрямую попадает в один класс с универсальными видеомоделями — Veo 3.1, Sora 2, обновлённым Kling AI 2.6 и Grok, которые также делают ставку на генерацию «всё сразу», без внешнего продакшена.

Итог: WAN 2.6 выводит линейку Alibaba на уровень универсальных видеомоделей: генерация сцен, стабильные персонажи, работа со звуком и изображениями теперь собраны в одном инструменте.

⭐ Тестим нейросети каждый день, а то, что реально работает — сливаем в Telegram-канал: .

Тэги Alibaba Wan Нейросети

Свежие комментарии